1robots设置robotstxt文件对于网站的作用就是告诉搜索引擎哪些页面不用抓取,比如一些死链重复的页面等2网站地图设置网站地图通常有两种,分别是提交给搜索引擎的地图和站内地图,前者的作用是为百度蜘蛛爬行网站提供方便,提供收录率,比如sitemapxml而后者是便于访客点击查看各级栏目的内容;尽管花了很多的功夫做了sitemap,但网站的录入依旧难以提升,关于这种现象,我们能够在建设网站地图之前,首先要推断下sitemap的用途到底是干嘛的,与网站是不是匹配,假设运营是一个每天浏览量很少的小型网站,而新添的网页数量在自个的可控范围,sitemap的实际效果是什么,为了增加网站的索引量,假设一个;Sitemap与Robotstxt之间是互补的,它们共同维护网站的抓取策略删除Sitemap URL时,只需在服务器端操作,搜索引擎会自动确认,但这并不影响已抓取的页面然而,建议通过robotstxt规则来阻止爬虫访问不希望被索引的页面,而非单纯依赖Sitemap的删除总的来说,Sitemap是搜索引擎优化的重要工具,合理的使用;robotstxt协议是一种存放于网站根目录下的ASCII编码的文本文件,它用于告诉网络搜索引擎的漫游器又称网络蜘蛛,此网站中的哪些内容是不应被搜索引擎的漫游器获取的,哪些是可以被漫游器获取的因为一些系统中的URL是大小写敏感的,所以robotstxt的文件名应统一为小写,并放置于网站的根目录下简单;并且你为这些动态网页创建了静态副本,以供搜索蜘蛛更容易抓取那么你需要在robotstxt文件里设置避免动态网页被蜘蛛索引,以保证这些网页不会被视为是网站重复的内容robotstxt文件里还可以直接包括在sitemap文件的链接就像这样Sitemap;robots协议文件于SEO角度的使用通过Robots协议,网站可以屏蔽一些对爬虫不友好的页面,如网站后台临时活动页面等,以避免资源浪费通常情况下,Robots文件会禁止爬取网站后台在Robots协议中添加Sitemap链接有助于爬虫更高效地抓取网站页面百度官方建议仅当网站包含不希望被搜索引擎收录的内容时,才需要使用Robot;Robots文件是指导搜索引擎爬虫访问网站的文本文件,一般位于根目录下,文件名为quotrobotstxtquot通过配置,可控制爬虫行为,如允许或禁止访问特定页面,限制抓取频率,指定服务器带宽等常见的Robots文件设置包括1 Useragent用于指明适用于哪些搜索引擎爬虫的规则例如,Useragent Googlebot,表示该。

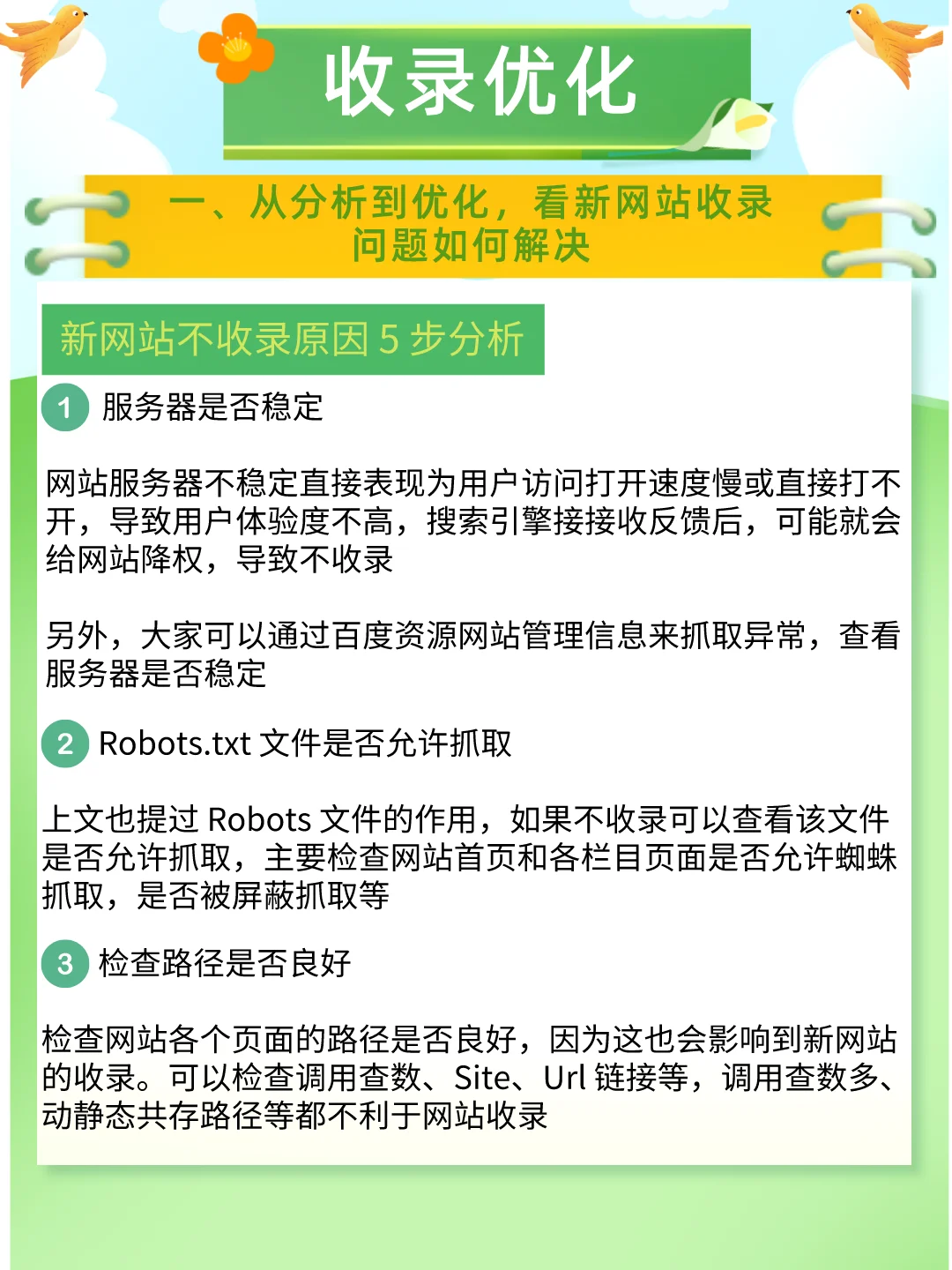

作用robotstxt文件用于控制搜索引擎蜘蛛的爬行行为,可以阻止不必要的文件被爬行,从而引导搜索引擎更高效地获取网站的主要内容操作检查robotstxt文件是否设置正确,确保重要页面被允许访问,同时阻止不必要的文件或目录被索引优化点击率较低的页面 分析原因点击率较低的页面可能存在问题,如内容布局;XML格式提供更多信息,如页面优先级最后修改时间等,但搜索引擎对此要求不统一,需针对每个搜索引擎维护特定格式TXT格式更简单,仅包含URL,信息有限,适用于内容较少的网站生成Sitemap时的注意事项与Robotstxt规则协调避免冲突,例如,已标记为“noindex”的页面不应出现在Sitemap中删除;Robotstxt 对 SEO 的作用主要体现在优化抓取预算和屏蔽重复私密页面如果网站页面众多且超过了搜索引擎分配的预算,合理使用 robotstxt 可以阻止一些无用页面被爬取,节省抓取预算,确保重要页面被抓取并被索引,从而提高排名同时,屏蔽重复页面和私密页面可以优化资源分配,提高网站质量Robotstxt 文。

检查robotstxt文件确保未屏蔽360蜘蛛访问,允许其抓取网站内容登录360站长平台进行URL收录提交等操作提高360收录概率的其他建议进行SEO优化优化内容质量提升网站访问速度丰富内链结构以及增加外部链接等,使网站更符合搜索引擎的抓取规则避免作弊行为检查网站内部是否存在内容重复过度优化;什么是Sitemap网站地图Sitemap网站地图是提供网站信息的文件,一般命名为sitemapxml制作并提交给搜索引擎有助于网站内容完全被收录,包括较深的页面这是与搜索引擎沟通的有效方式什么是robotstxtrobotstxt是在网站根目录下的文件,通过代码控制搜索引擎蜘蛛抓取行为通过它,可以限制或;自动推送通过在网站上嵌入特定的JS链接推送代码,实现每次页面浏览时自动提交URL至360蜘蛛sitemap提交创建sitemap地图,覆盖网站内的所有链接,但抓取周期较长,更新不及时URL收录用户可以主动提交链接,但每次手动提交有限制使用360推送工具前的准备工作检查robotstxt文件确保未屏蔽360蜘蛛访问。

Sitemap和Robotstxt使用Sitemap告诉搜索引擎你的网站的页面,并使用Robotstxt文件告诉搜索引擎哪些页面不需要被爬取响应式设计使用响应式设计,以确保你的网站在移动设备和桌面设备上都很好地显示在开发Vue网站时,记得遵循这些SEO建议,以确保你的网站在搜索结果中得到最好的曝光;如果想让搜索引擎停止访问站点地图中列出的网址,请使用Robotstxt规则来实现综上所述,Sitemap是网站优化中的重要工具,但并非所有网站都需要创建在决定是否创建Sitemap时,需根据网站规模更新速度内容结构等因素综合考虑同时,还需注意Sitemap的格式选择与搜索引擎的兼容性以及Sitemap与Robotstxt的;robotstxt是搜索引擎中访问网站的时候要查看的第一个文件Robotstxt文件告诉蜘蛛程序在服务器上什么文件是可以被查看的当一个搜索蜘蛛访问一个站点时,它会首先检查该站点根目录下是否存在robotstxt,如果存在,搜索机器人就会按照该文件中的内容来确定访问的范围如果该文件不存在,所有的搜索蜘蛛将;robotstxt的用法1创建robotstxt文件,通常,这个文件应该保存在网站的根目录下2确定拒绝搜索引擎访问的网页,要做到这一点,你需要确定哪些页面你不希望出现在搜索结果中,是因为这些页面包含了敏感信息早已过时并不再适用,或是属于单个用途的网页比如结果页面等对于想要允许在搜索引擎中。

首先,运用robotstxt文件来引导爬虫这一步至关重要,因为它告诉爬虫哪些页面可以访问,哪些不可以进一步地,可以结合sitemap来提供详细的网站地图,这有助于爬虫更高效地抓取网站内容,减少无意义的工作其次,提升站点的吸引力创建高质量原创内容并保持更新的频率,以保持站点的活力更新时间的一致。

转载请注明来自中国金属学会,本文标题:《seo网站建设中robots.txt和sitemap的作用是什么》

京公网安备11000000000001号

京公网安备11000000000001号 京ICP备11000001号

京ICP备11000001号

还没有评论,来说两句吧...